Prequisite (Harus terlebih dahulu install)

- Hadoop 3.1 (Lihat disini)

- Java JDK 8

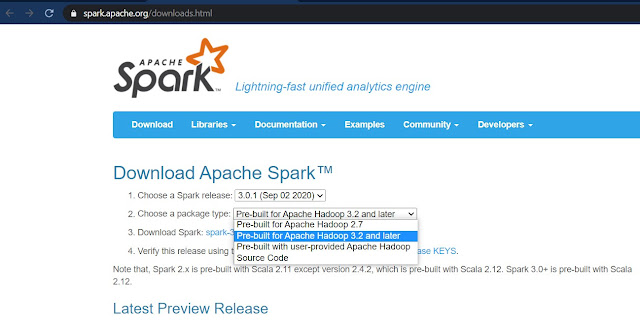

1. Pertama untuk instalasi kita harus mendownload terlebih dahulu apache spark-nya seperti berikut

plih apache spark sesuai hadoop yang digunakan karna saya menggunakan hadoop 3.1 jadi gunakan apache spark prebuilt hadoop 3.2

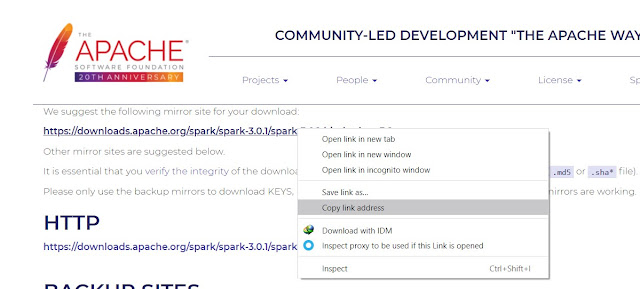

lalu copy link addressnya

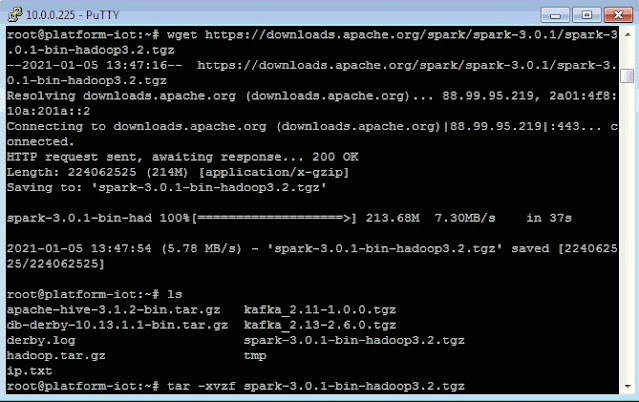

kemudian jalankan perintah wget [link yang dicopy]

kemudian extract dengan perintah tar -xvzf [file yang sudah terdownload]

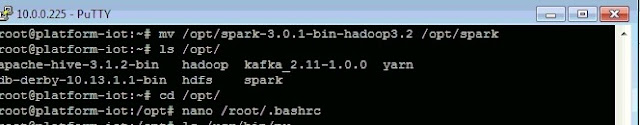

2. Setelah selesai didownload ubah nama folder menjadi spark kemudian pindahkan ke folder tempat semua aplikasi yang menyangkut dengan hadoop

lalu jalankan perintah # source /root/.bashrc ATAU source /etc/profile

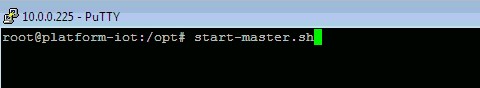

4. setelah selesai semua jalankan perintah berikut untuk

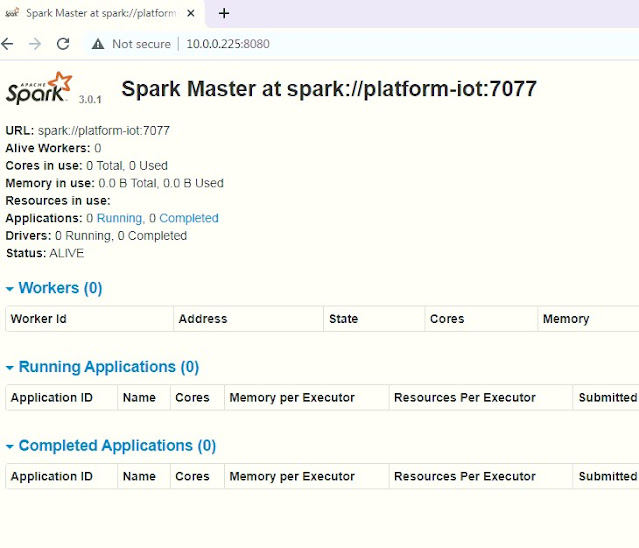

karna sekarang kita berada di mesin hadoop master maka jalan perintah start-master.sh ketika sudah berjalan kita bisa cek dengan ketik di browser kita http://[ip-mesin-master]:8080

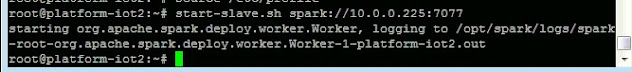

sedangkan untuk client / worker jalankan perintah # start-slave.sh spark://[ip-mesin-master]:7077 nah maka dari itu untuk menjalankan di Mesin Slave/Worker kita harus melakuka proses instalasi seperti cara diatas pada mesin slave tetapi jalankan perintah start-slave seperti contoh diatas agar menjadi spark cluster.

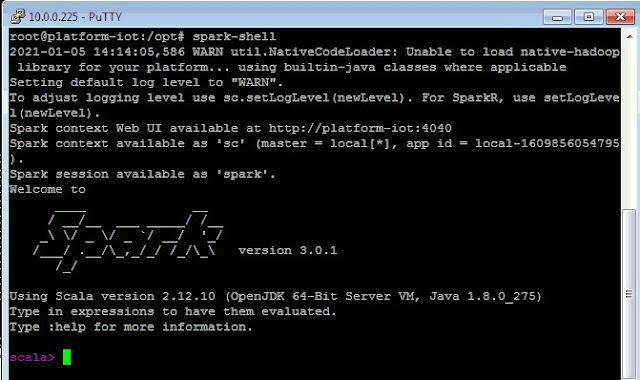

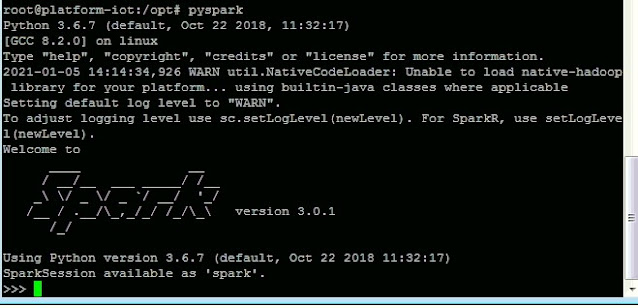

5. Nah setelah selesai semua kita bisa menjalankan apache spark dengan menggunakan bahasa program Scala dengan menjalankan perintah spark-shell seperti berikut

Nah setelah bisa semua kita akan menjalankan program wordcount di apache spark, pada kesempatan kali ini saya menjalankan program wordcount dengan bahasa program scala yaitu dengan spark-shell akan tetapi kita juga bisa menjalankan program wordcount di apache spark dengan bahasa program python denga pyspark bahkan kita juga bisa menggunakan bahasa program JAVA. [lihat disini]

Wordcount Program with Scala Apache Spark

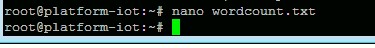

1. Pertama kita harus membuat file wordcount.txt dan isi file sesuai kehendak teman2 disini mengambil contoh kalimat seperti berikut:

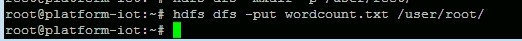

2. Setelah itu kita harus membuat direktori di hdfs agar spark bisa membaca file dari hadoop kita dengan perintah berikut :

# hdfs dfs -mkdir -p /user/root/

kemudian upload file yang telah dibuat ke direktori hdfs dengan perintah :

lalu masuk kembali ke spark-shell :

disini kita inisialkan isi file kedalam bentuk data bertipe string

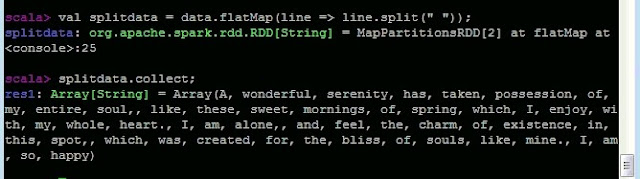

kemudian disini setiap kata di split atau dipisahkan berdasarkan spasi maka setiap kata akan dipisahkan dengan koma

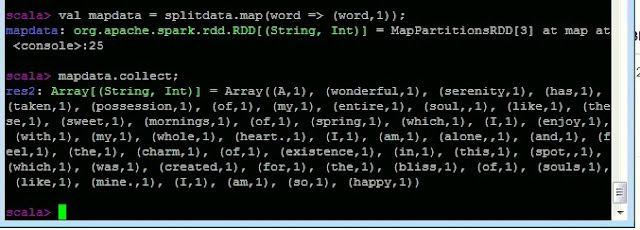

Disini kata yang sudah dipisahkan dengan koma kita jalankan fungsi map untuk menghitung jumlah dari setiap kata. Maka dari sini sudah terlihat setiap jumlah kata terhitung

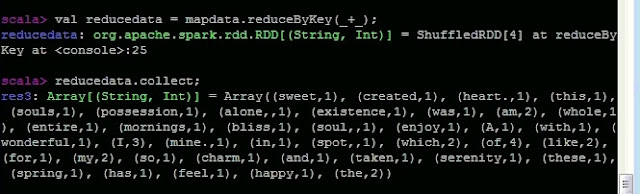

lalu kita bisa melakukan mapreduce dari data diatas yg sudah di hitung jumlah katanya.

0 Comments